科技數據收集與處理 從海量信息到精準洞察

在當今以數據驅動的科技時代,數據已成為與土地、勞動力、資本和技術并列的關鍵生產要素。科技數據的收集與處理,是挖掘其價值、驅動創新的核心環節。本文將探討這一過程的關鍵步驟與意義。

一、數據收集:構建價值的基石

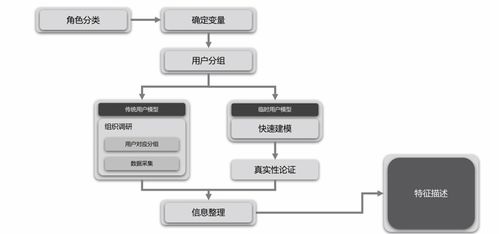

數據收集是數據處理流程的起點,其質量直接決定后續分析的深度與廣度。科技領域的數據收集主要包含以下幾個層面:

- 來源多樣化:數據可來自物聯網傳感器、網絡日志、移動應用、科學實驗、社交媒體、公共數據庫及商業交易等。例如,智能工廠的傳感器實時采集設備運行參數,天文望遠鏡持續捕捉深空影像數據。

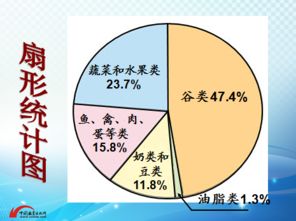

- 類型復雜化:除了傳統的結構化數據(如數據庫表格),更多的是半結構化(如JSON、XML文件)和非結構化數據(如文本、圖像、音頻、視頻)。例如,一篇科研論文的文本、其中包含的圖表以及相關的實驗視頻,共同構成了一個多模態數據集。

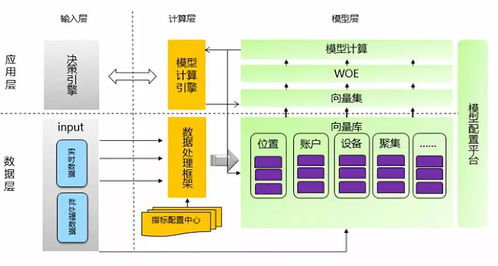

- 實時性要求高:許多應用場景,如自動駕駛、金融風控和工業監控,要求數據能夠被近乎實時地收集和響應,這對采集系統的吞吐量與延遲提出了嚴峻挑戰。

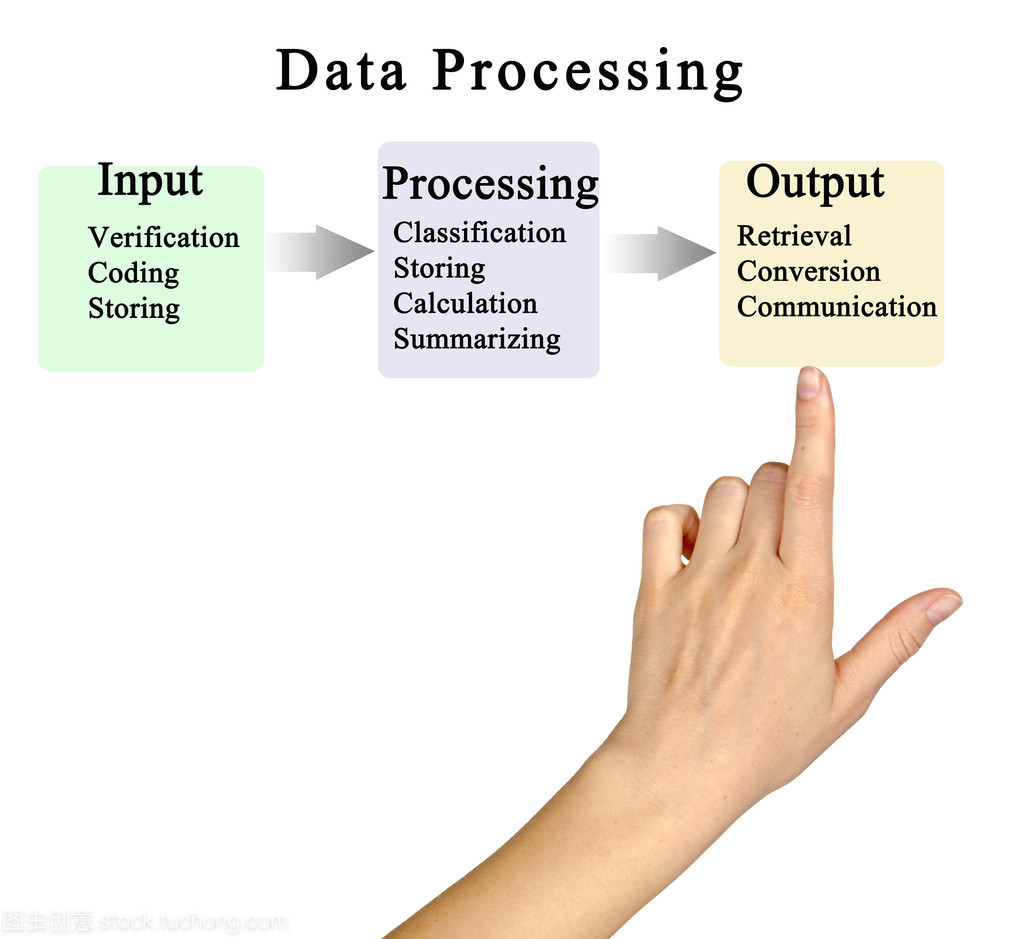

二、數據處理:從原始信息到可用知識

原始數據通常存在噪聲、不一致、不完整等問題,無法直接用于分析。數據處理正是為了將“原始礦石”冶煉成“高純金屬”,其核心流程包括:

- 數據清洗與預處理:這是至關重要的一步,涉及處理缺失值、糾正錯誤、識別并移除異常值、統一數據格式與單位等。例如,在生物信息學中,需要對基因測序產生的海量原始讀數進行質量控制和糾錯。

- 數據整合與轉換:將來自不同源頭、格式各異的數據進行整合,消除冗余與矛盾,并轉換為適合分析的統一形式。這可能涉及數據融合、歸一化、聚合以及特征工程(即從原始數據中構建更有意義的特征變量)。

- 數據存儲與管理:根據數據的結構、規模和訪問模式,選擇合適的存儲方案,如關系型數據庫、NoSQL數據庫、數據湖或數據倉庫。高效的數據管理系統是確保數據可用性、安全性與完整性的基礎。

- 分析與建模:利用統計分析、機器學習、數據挖掘等技術,從處理好的數據中發現模式、趨勢、關聯和洞見。例如,通過處理用戶行為數據,科技公司可以構建推薦模型;通過分析天文數據,科學家可能發現新的天體現象。

三、關鍵技術與挑戰

科技數據的處理依賴于一系列前沿技術:

- 分布式計算框架:如Apache Hadoop、Spark,用于處理PB乃至EB級別的海量數據。

- 流處理技術:如Apache Flink、Kafka Streams,滿足實時數據處理需求。

- 云平臺與容器化:提供了彈性、可擴展的計算與存儲資源。

- 人工智能與機器學習:不僅是數據分析的工具,其自身訓練也產生了巨量數據,形成了數據收集與處理的閉環。

面臨的挑戰同樣突出:數據隱私與安全(如GDPR等法規)、數據質量保障、處理系統的能耗問題、以及跨領域、跨模態數據融合的復雜性。

四、價值與展望

高效的數據收集與處理,最終將數據轉化為可行動的見解與決策支持,驅動科技創新:

- 加速科學研究:如在高能物理、氣候模擬等領域,實現從數據到發現的快速循環。

- 賦能產業發展:優化生產流程、實現預測性維護、創造個性化產品與服務。

- 提升社會治理:在智慧城市、公共健康等領域實現更精細化的管理。

隨著邊緣計算、人工智能原生數據庫、隱私計算等技術的發展,數據收集與處理的邊界將進一步延伸,過程將更加智能化、自動化與安全化,持續釋放數據作為核心生產要素的巨大潛能。

如若轉載,請注明出處:http://m.jzgcc.cn/product/51.html

更新時間:2026-01-12 02:21:25